网站介绍

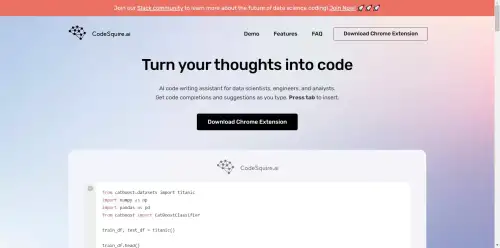

CodeSquire 是一款 ai 代码编写助手,可帮助数据科学家、工程师和分析师更快、更轻松地编写代码。

它用作 Chrome 扩展程序,可与 Google Colab、Jupyter Notebook、Databricks 和 BigQuery 等流行平台集成。CodeSquire 可以在您键入时提供代码完成和建议,将您的注释转换为代码,从自然语言指令编写 SQL 查询,以纯文本形式解释代码,以及通过指定多个步骤来编写复杂的函数。CodeSquire 使用高级 AI 模型来考虑您的数据列和类型,并适应您的代码风格和用例。CodeSquire 是一款功能强大的工具,可以通过编码提高您的生产力和创造力。

CodeSquire优点:

CodeSquire可以通过提供智能代码建议和补全来帮助数据科学家和工程师更快、更轻松地编写代码。

它可以将注释转换为代码,根据指令编写 SQL 查询,以纯文本形式解释代码,并通过指定多个步骤来编写复杂的函数。

它支持各种平台,例如 Google Colab、JupyterLab、Jupyter Notebook、BigQuery 和 Databricks。

CodeSquire使用高级 AI 模型来考虑用户的数据列和类型。

CodeSquire缺点:

它可能无法处理所有编码方案或语言,并且可能需要用户进行一些手动编辑或调试。

它可能与某些浏览器或设备不兼容,并且可能需要安装 Chrome 扩展程序。

它可能会引发一些关于代码所有权、剽窃或知识产权的道德或法律问题。

对于某些用户来说,它可能不是免费的或负担得起的,并且可能在使用或功能上有一些限制。

本站Ai工具导航提供的“CodeSquire”来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由“Ai工具导航”实际控制,在“2025-10-03 01:20:17”收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,“Ai工具导航”不承担任何责任。

流量统计

- 7天

- 30天

- 90天

- 365天

猜你喜欢

![JoyCode]()

JoyCode

JoyCode是什么JoyCode 是京东云推出的新一代智能编程 AI IDE ,通过 AI 技术为开发者提供高效、智能...![Kiro]()

Kiro

Kiro是什么Kiro 是亚马逊公司推出的 AI IDE,帮助开发者从概念到开发高效交付。Kiro 通过 Specs(S...![CodeBuddy IDE]()

CodeBuddy IDE

CodeBuddy IDE是什么CodeBuddy IDE是是腾讯推出的全栈开发AI IDE,将产品设计、研发部署全流程...![Claude Code]()

Claude Code

Claude Code是什么Claude Code 是 Anthropic 公司推出的基于命令行的 AI 编程工具。Cl...![Twinny]()

Twinny

Twinny是什么Twinny 是一个专为 VS Code 设计的AI代码补全插件,支持本地或API托管,提供智能代码自...![C知道]()

C知道

C知道是什么C知道是由开发者社区CSDN推出的一款AI技术问答工具,利用了自然语言处理技术和生成式AI,旨在为开发者提供...![Duo Chat]()

Duo Chat

Duo Chat是什么Duo Chat 是源代码管理平台 GitLab 推出的一款对话式AI编程助手,旨在通过自然语言交...![Plandex]()

Plandex

Plandex是什么Plandex是一个基于终端的开源 AI 编程引擎,可帮助程序员完成复杂的软件编程开发任务、解决不良...![Devin]()

Devin

Devin是什么Devin是由人工智能初创公司Cognition推出的全球首个全自主的AI软件工程师智能体,具备强大的编...![Tabby]()

Tabby

Tabby是什么Tabby是一个自托管的AI编程助手,为开发人员提供了一个开源和本地部署的替代方案,支持通过利用第三方开...![DevChat]()

DevChat

DevChat是一个开源的AI编程助手,可以帮助开发人员高效地利用AI进行代码生成和文档记录。其核心理念是让开发者以提示...![JetBrains AI]()

JetBrains AI

JetBrains AI是编程软件开发公司JetBrains最新为其旗下系列IDE推出的类似于GitHub Copilo...

- 关注我们

-

扫一扫二维码关注我们的微信公众号

- 网址推荐

- 热门标签

-

- 游戏(4428)

- 街机游戏合集(4329)

- 街机游戏(4329)

- 在线游戏集合(4329)

- 街机在线(4329)

- nes合集游戏(4328)

- 在线小游戏网站(4328)

- 游戏榜(4328)

- 红白机游戏盒(4328)

- 小霸王游戏(4328)

- GBA(1796)

- 街机(555)

- 动作冒险(400)

- 青檬花园(374)

- 角色扮演(354)

- 动作(341)

- 汉化(332)

- SFC(328)

- 运动比赛(321)

- 深度导航(309)

- 小游戏(302)

- 射击(292)

- AIGC导航(277)

- 国内精选服务商(255)

- 中文(245)

- 冒险(239)

- 工具达人(239)

- AI写作工具(232)

- 平台(219)

- 格斗(212)

- 视频(198)

- 翻译(186)

- 人工智能(172)

- 动漫(159)

- 的(153)

- Video(152)

- 数字人(151)

- ppt(137)

- 数据分析(137)

- 文生图(134)

- logo(133)

- 飞行射击(128)

- AI智能体(126)

- 赛车(124)

- 一起用AI(123)

- 电商(119)

- 其他(119)

- 思维导图(113)

- OpenI(113)

- Code(105)